| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- cvpr 논문 리뷰

- ICLR

- Segment Anything

- deep learning

- 논문리뷰

- 자기지도학습

- iclr 2024

- Self-supervised learning

- Data-centric AI

- Segment Anything 설명

- Computer Vision

- Prompt란

- Segment Anything 리뷰

- Data-centric

- CVPR

- deep learning 논문 리뷰

- iclr spotlight

- Multi-modal

- iclr 논문 리뷰

- Computer Vision 논문 리뷰

- VLM

- active learning

- ssl

- Meta AI

- Prompt Tuning

- 논문 리뷰

- contrastive learning

- Stable Diffusion

- ai 최신 논문

- cvpr 2024

- Today

- Total

Study With Inha

[Paper Review] ICLR 2024 Oral Paper, Is ImageNet worth 1 video? Learning strong image encoders from 1 long unlabelled video 논문 리뷰 본문

[Paper Review] ICLR 2024 Oral Paper, Is ImageNet worth 1 video? Learning strong image encoders from 1 long unlabelled video 논문 리뷰

강이나 2024. 7. 20. 00:54

ICLR 2024 Oral Paper,

Is ImageNet worth 1 video?

Learning strong image encoders from 1 long unlabelled video

논문 링크: https://openreview.net/forum?id=Yen1lGns2o

Is ImageNet worth 1 video? Learning strong image encoders from 1...

Self-supervised learning has unlocked the potential of scaling up pretraining to billions of images, since annotation is unnecessary. But are we making the best use of data? How more economical can...

openreview.net

1. Introduction

본 논문은 ICLR 2024에서 Self-supervised Learning (SSL) 관련 Oral Paper로 선정된 논문이다.

딥러닝에서 Self-supervised Learning 방법론들이 각광을 받기 시작한 이유는 따로 labeling을 하지 않은 대용량 데이터에로 모델의성능을 높였기 때문이다.

이는 labeling cost를 줄이면서도 대용량 데이터를 통해서 general feature를 모델이 스스로 학습할 수 있도록 했다.

(SSL 관련 기본 개념 설명 포스팅 링크)

하지만 본 논문은 이런 unlabeled large dataset이 모델을 pretrain하는 데에 가장 효과적인 방법인가? 라는 질문을 던지며 시작한다.

인간은 여러 장의 이미지를 통해 visual system 기능을 향상시키는 것이 아니라,

거대한 "continuous stream"을 통해서 visual system을 빠르게 향상시킬 수 있었다고 한다.

따라서 모델 또한 여러 장의 대용량 이미지로 pretrian하는 것보다 인간의 시각에서 본 것과 같은 거대한 하나의 비디오로 학습하는 것이 더 효율적일 수 있다는 아이디어를 제시하고 있다.

이를 위해서 "Walking Tours"라는 인간의 시각에서 촬영된 1~3시간 분량의 continous egocentric(1인칭) 4K 비디오 데이터셋을 제시했다.

인간이 걸어다니면서 촬영한 것 같은 비디오를 통해서 어린 아이가 세상을 처음 마주했을 때 배경과 사물에 대한 차이점을 인지하면서 물체를 tracking하는 것을 배우는 것과 유사하다.

Walking Tours(WT)는 이전에 존재했던 비디오 데이터들이 object 중심으로 촬영되었던 것과 달리, 자연 상태 그대로를 관찰하면서 촬영했다는 것이 가장 큰 차이점이다.

이런 방식을 통해 학습되는 것을 "Discovered and tRAcked (DoRA)" 라고 명명했으며,

이는 주어진 video clip의 첫 번째 frame에 존재하는 object를 찾아내고 트래킹하는 'tracks to learn to recognize' end-to-end training approach이다.

그 결과 image segmentation이나 detection과 같은 downstream task에서 하나의 비디오로 pretrain된 모델이 ImageNet-level의 대용량 데이터셋으로 pretrain된 모델보다 좋은 성능을 보였다고 한다.

이러한 결과로 미루어 봤을 때, 본 논문에서 제시하는 DoRA는 앞으로 SSL 학습을 시킬 때 비디오 데이터셋을 효율적으로 사용할 수 있는 새로운 방법이라고 볼 수 있다.

2. Walking Tours Dataset

2.1 DATASET COLLECTION AND PROPERTIES

본 논문에서 제시하는 "Walking Tours (WTours, or WT)" Dataset은 urban scene을 촬영한 총 10개의 egocentric video들로 이루어져 있다.

Europe 및 Asia 지역의 도심을 걸으며 촬영한 듯한 비디오는 Amsterdam, Bangkok, Chiang Mai, Istanbul, Kuala Lampur, Singapore, Stockholm, Venice, and Zurich뿐만 아니라 Wildlife safari의 비디오도 포함되어 있다고 한다.

가장 짧은 비디오는 Wildlife safari를 담은 55분짜리 영상이고, 가장 긴 영상은 Bangkok에서 촬영된 2시간 55분짜리 영상이며, 비디오들의 평균 길이는 1시간 38분이라고 한다.

WT는 egocentric dataset을 SSL pretraining에 활용하여 학습하고 평가한 첫 번째 데이터셋이라고 한다.

Walking Tours Dataset이 가진 특징은 아래와 같다.

1. Large number of objects and actions: 비디오에는 많은 object와 walking, riding a bike, sitting, drinking 등의 다양한 액션이 포함되어 있음.

2. Natural transition in lighting conditions: 몇몇 비디오에는 시간이 지남에 따라 빛이 점점 밝아지거나 어두워지는 등 다양한 lighting transition들이 포함되어 있음.

3. Natural transition in scenes: 여러 장소들을 옮겨 다니며 생기는 transition들(e.g. city center -> market place -> residential areas -> parks -> water fronts)이 포함되어 있음.

4. Natural object augmentations: pose, deformation, viewpoint, perspective distortion, relative object position, occlusion, background clutter과 같은 다양한 연속적인 variation들이 포함되어 있어 augmentation 효과를 얻을 수 있음.

2.2 COMPARISON WITH OTHER VIDEO DATASETS

WT 데이터셋을 기존의 다른 egocentric (1인칭) 비디오 데이터셋들과 비교해보면 아래와 같은 특징들이 존재한다.

- 데이터셋의 지속 시간 및 해상도: WT는 다른 egocentric 비디오 데이터셋보다 더 길고 고해상도(4K)임.

- 객체의 다양성: WT 데이터셋은 프레임당 객체 수가 많고 고유한 객체 클래스가 많아, representation learning에 적합함.

- visual learning 적합성: WT는 자연스러운 장면 전환과 조명 변화가 특징이며, 수동 labeling이 필요 없어 자동으로 더 많은 비디오를 추가할 수 있음.

- 기존 데이터셋과의 차이점: WT는 pretraining에 사용된 기존 비디오 데이터셋과 달리, 더 연속적이고 긴 비디오를 사용함. 다른 데이터셋은 짧고 저해상도이며 vido-text pair와 같은 weak annotation에 의존하거나, 특정 class에는 balance를 맞춰주기 위한 작업이 필요하기도 함.

이러한 특성 덕분에 WT 데이터셋은 자율 학습 및 다양한 downstream task에 유용한 strong visual learning을 가능하게 한다.

2.3 DATASET ANALYSIS

본 파트에서는 모두 동일한 길이의 비디오라는 조건 아래에, 두 개의 다른 비디오 데이터셋과 두 개의 다른 영화 비디오와 a single WTours 비디오를 비교하여 WTours의 특성을 분석했다.

Figure 2(a)에서는 SSL pretraining에서 잘 탐구되지 않던 밝기 변화에 대해서 분석하고 있다.

WT는 scene이 점점 밝아지거나 점점 어두워지는 등 점차적으로 밝기가 변하는 반면,

Epic-Kitchens와 AVA 비디오같은 데이터셋은 무작위로 밝기가 변하고 있다는 것을 알 수 있다.

Figure 2(b,c)에서 볼 수 있듯, WTours에는 다른 데이터셋보다 unique class가 더 자주 나타날 뿐만 아니라 프레임당 unique class 수가 더 많기 때문에 semantically rich한 데이터셋이 될 수 있었다고 한다.

Figure 2(d)에서 WTours와 Epic-Kitchens 비디오는 평균적으로 전체 비디오당 1-2개의 shots(편집된 장면 전환)만 포함하는 반면, 다른 데이터셋은 수백 개의 shots를 포함하고 있다.

실험 결과 WTours가 downstream tasks에서 영화보다 훨씬 뛰어남을 확인했는데,

이는 영화나 다른 데이터셋에는 편집으로 인한 장면 전환이 무수히 일어나는 반면

WTours는 편집으로 인해 생략된 장면 전환이 거의 없기 때문에 모델이 일관된 시각적 정보를 학습할 수 있었기 때문이라고 분석하고 있다.

3. Attention-based Multi-object Tracking

본 논문에서 제시하는 DoRA의 목표는 video frame에 있는 풍부한 정보들을 활용하여 strong representation learning이 가능하도록 하는 것이다.

Standard SSL framework에서는 같은 class나 scene을 서로 다른 뷰에서 관찰하더라도 correspondence가 있다는 것을 가정하고 학습을 진행한다.

이처럼 이미지에 대한 학습을 진행할 때는 correspondence를 설정하는 것이 간단할 수 있지만,

시간의 경과에 따라 object가 이동하거나 배경이 급격하게 변화할 경우 프레임 간의 correspondence를 찾는 것이 어려워지기도 한다.

또한, 큰 field of view를 가진 비디오나 ego-motion이 있는 경우 복잡한 배경이나 물체의 움직임이 포함될 가능성이 더 커지기 때문에 correspondence를 얻는 것이 더욱 어려워지기도 한다.

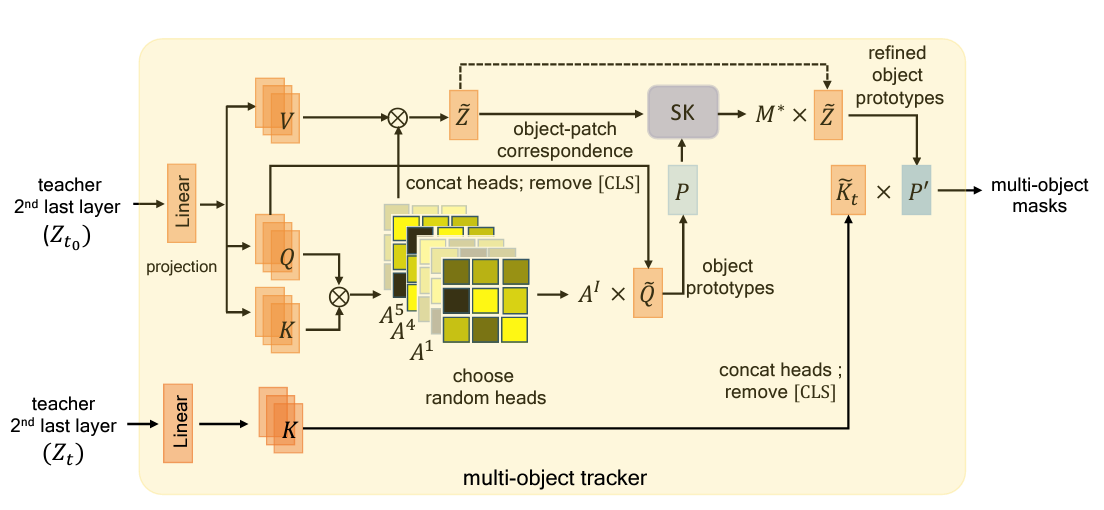

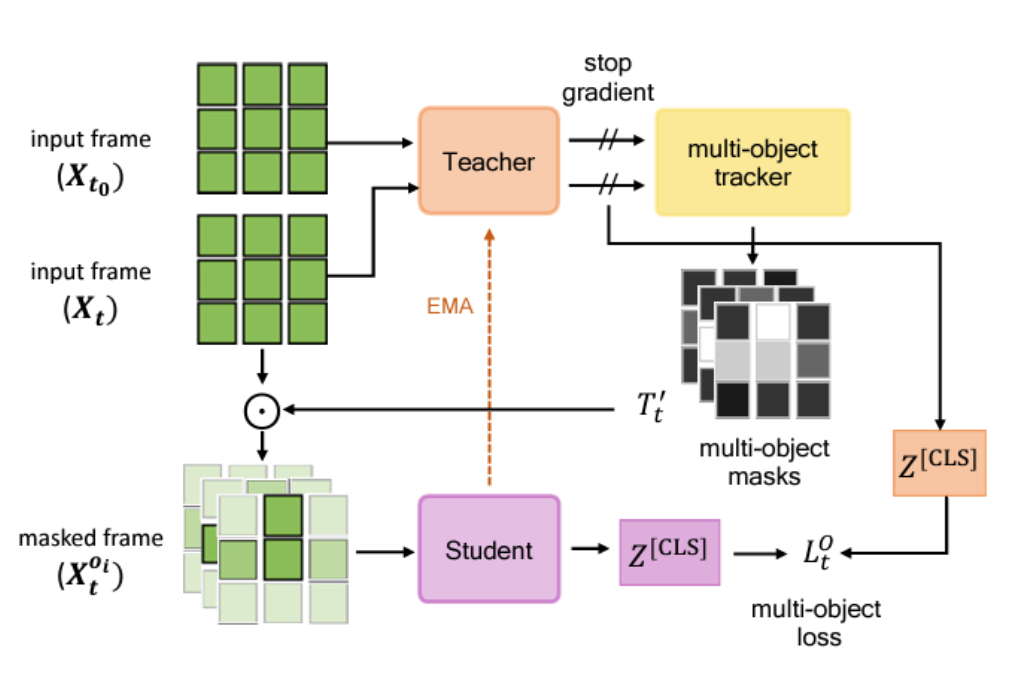

이를 고려하여, DoRA는 teacher-student의 distillation 구조에서 각 vision transformer [CLS] token의 attention을 활용하여

주어진 프레임 내 여러 객체를 식별하고 일관되게 추적할 수 있도록하는 'multi-object Discovery and tRAcking'을 뜻한다.

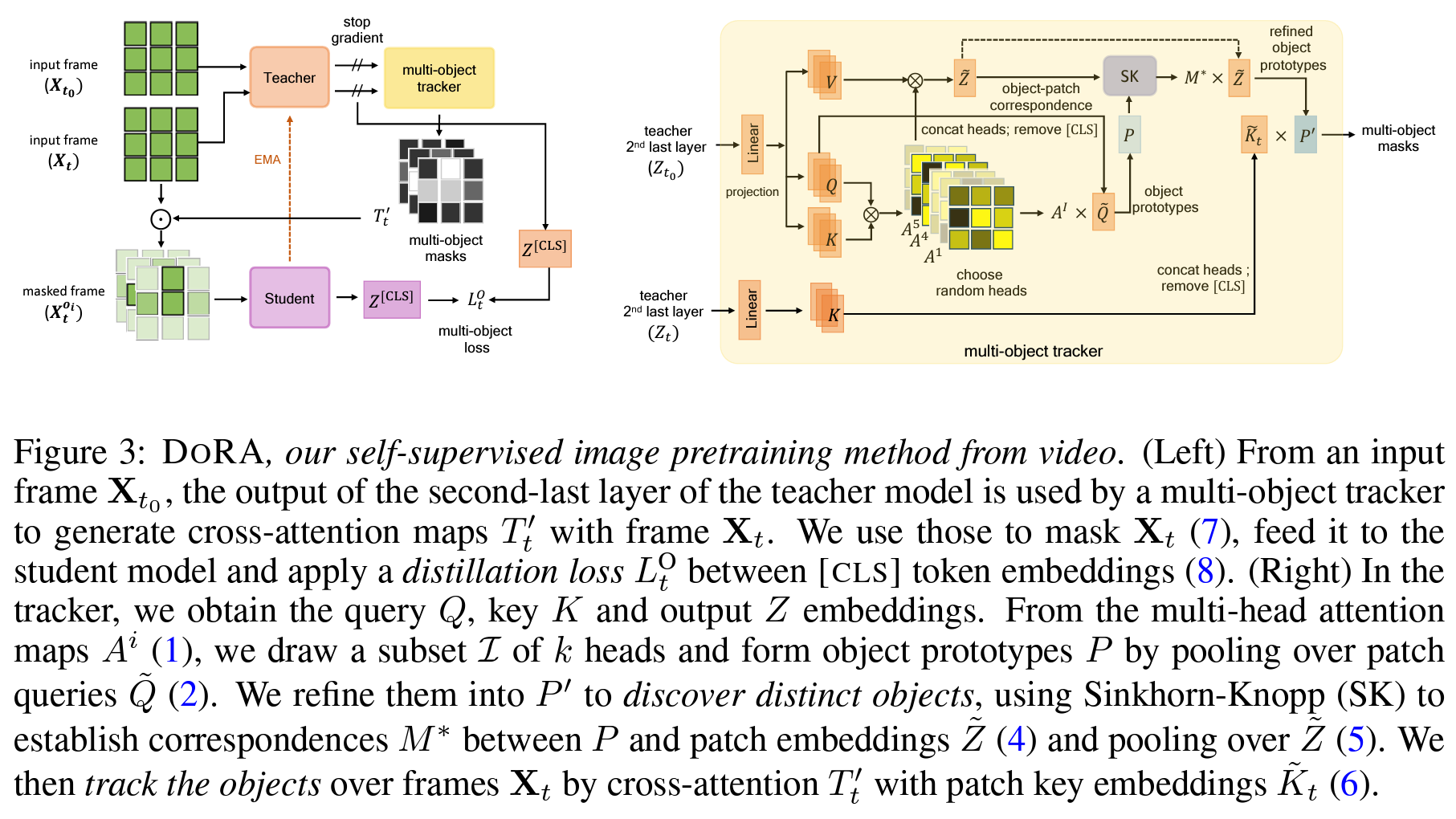

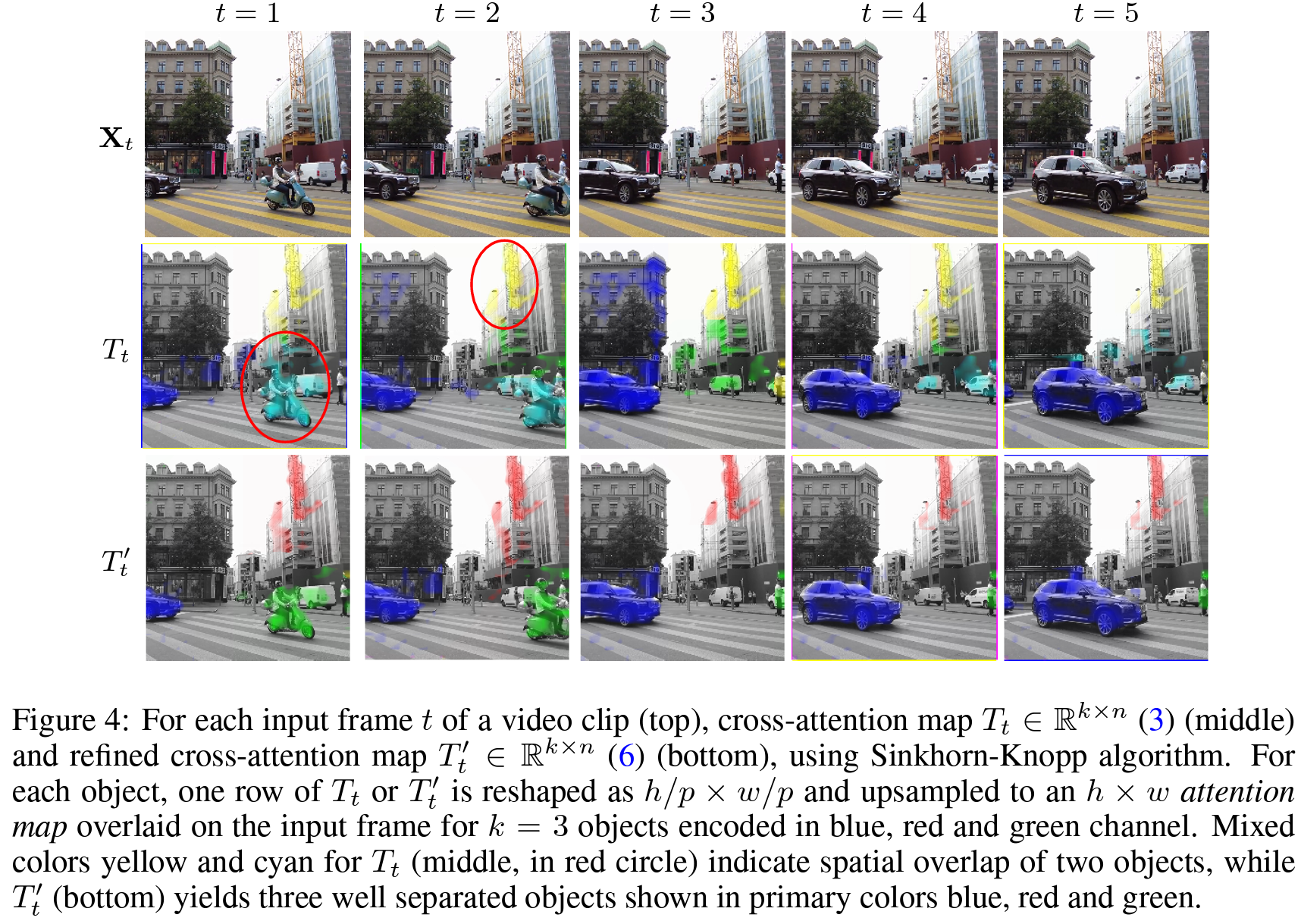

Figure 3에서 보이는 것처럼, 비디오 프레임들은 아래와 같이 토큰화되어 Vision Transformer의 encoder에 입력되게 된다.

- 주어진 video clip이 총 T frames로 이루어져 있을 때, t∈{1,...,T} 번째 프레임은 Xt∈Rh×w×c라 정의할 수 있음

- 각 frame은 서로 겹치지 않는 n=hw/p2개의 토큰으로 토큰화 됨

- 각 토큰 패치들이 Vision Transformer Encoder를 거친 후인 output embedding Zt∈R(n+1)×d는, d dimension으로 projection된 후 [CLS] 토큰이 추가된 것임

전체적인 구조는 DINO의 teacher-student 구조를 참고했다고 한다.

student model의 파라미터(θ)와 이와 완전히 동일한 구조를 가진 teacher model의 파라미터(θ′)는 exponential moving average를 통해 업데이트 되게 됨

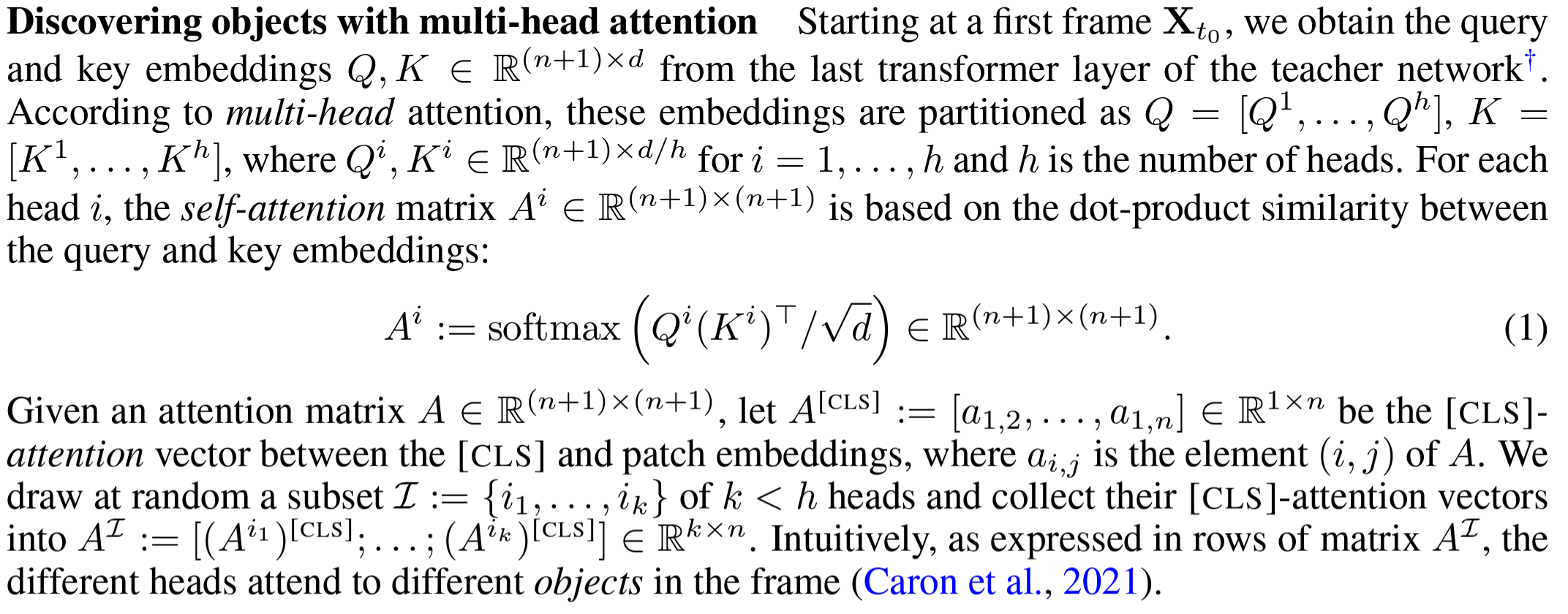

Discovering objects with multi-head attention

비디오의 첫 프레임부터 시작하여 teacher network의 transformer layer에 의해 key, query embedding을 얻을 수 있으며,

key와 query의 simailarity를 dot-product 연산을 통해 계산을 하면 아래와 같이 multi-head의 self-attention matrix를 구할 수 있게 된다.

embedding space에서 k개의 object를 표현하기 위해서 object prototype을 정의했으며,

이는 t0 frame에 존재하는 k개의 objects를 full embedding space 상에서의 k개의 서로 다른 [CLS] token의 representation로 표현한 것을 뜻한다.

(즉, object prototype은 해당 object를 잘 표현한 representation이라고 생각할 수 있다)

그 후에는 t번 째 frame의 key embedding이 주어지면 cross-attention 연산을 통해서 해당 object를 tracking할 수 있게 되는 것이다.

그 후, Teacher 모델과 Student 모델 간에 Distillation Loss를 적용하여 학습을 진행하게 된다.

Teacher 모델의 attention 맵을 기반으로 Student 모델이 동일한 객체를 추적할 수 있도록 학습하는 것이며,

이는 학습된 모델이 다양한 프레임에서 일관되게 객체를 인식하고 추적하도록 돕는 역할을 하게 된다.

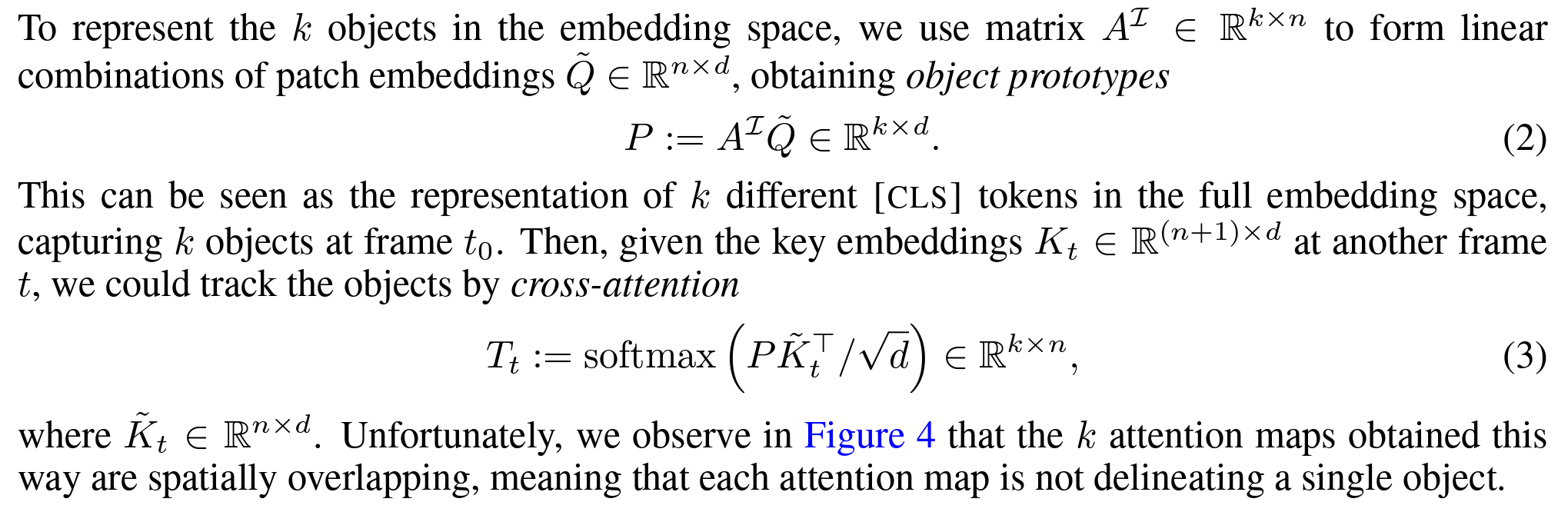

Establishing object-patch correspondences

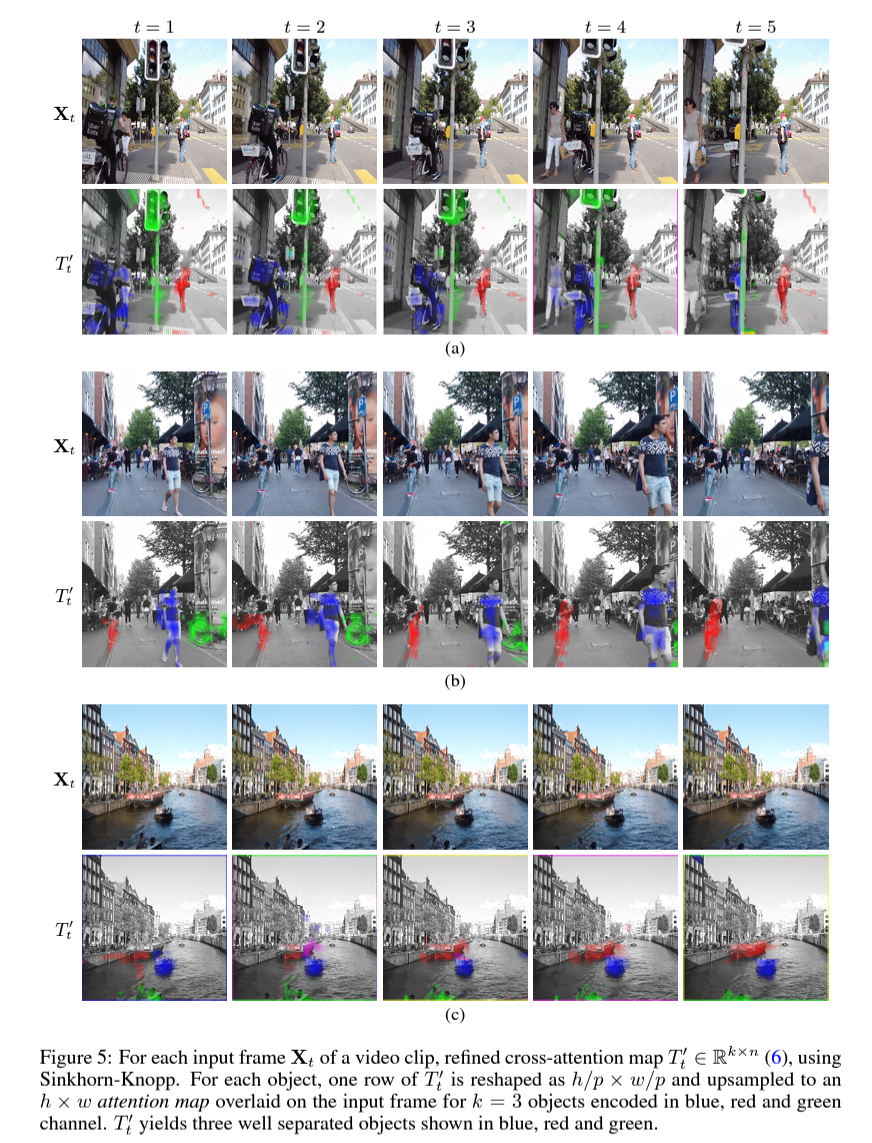

하지만 위와 같은 방법으로 k attention map을 구했을 때 아래의 Tt에서 cyan색이나 yellow색으로 표시된 부분과 같이,

single object에 대한 attention map이 나타나는 것이 아니라 spatially overlapping된 부분들이 존재했다고 한다.

(원래는 class prototype의 경우 해당 object만의 고유한 representation을 담고 있기를 바란 것이므로 T′t에서 볼 수 있듯이 k=3이므로 R, G, B 컬러로만 attention map이 나오기를 기대함)

따라서 공간적으로 완전히 독립된 (spatially distinct한) object를 구하기 위해서 prototype과 patch token간의 correspondence를 계산했다고 한다.

- Z가 t0 frame의 teacher network를 통과한 output embedding일 때, 각 object를 뜻하는 row P∈Rk×d와 patch token인 ˜Z∈Rn×d 간의 correspondence를 구하려고 하는 것임

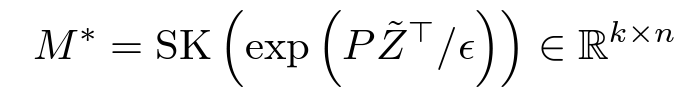

- 최종 목표는 transport plan M∈Rk timesn을 찾는 것: prototype과 patch embedding간의 최솟값을 찾는 것으로, uniform marginals 상에서 두 개의 joint probability를 뜻함

- 아래와 같은 Sinkhorn-Knopp (SK) algorithm을 통해서 각 row와 column들을 반복적으로 normalizing하면 M의 minimum solution을 구할 수 있음

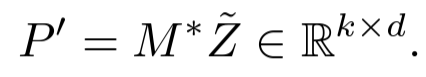

- 최종적으로 M∗를 활용하여 refined object prototype(P′)을 구할 수 있게 됨

- 그 후 다른 frame에서의 refined cross-attention(T′t)은 주어진 key embedding을 통해서 얻을 수 있게 된다. (모든 과정은 기존 과정에서의 attention matrix A 대신 M을 사용한다는 것 외에는 이전과 동일함)

- 이를 통해 object 간의 공간 상의 overlapping 되는 부분 없는 정제된 cross-attention map을 얻을 수 있게 되었고, 결국 SSL에서 서로 다른 object들의 spatial correspondence를 효율적으로 re-balance할 수 있게 된 것임.

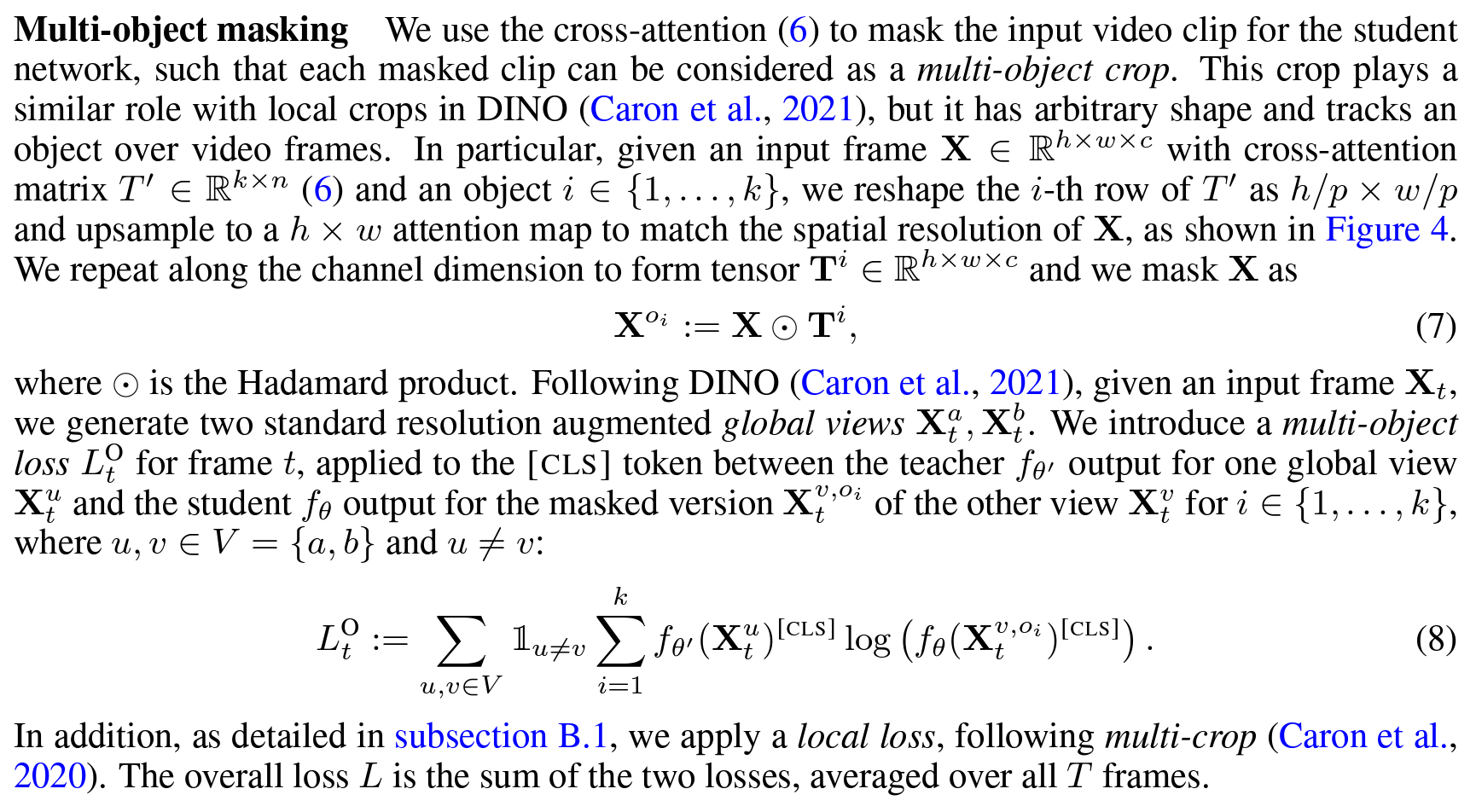

Multi-object Masking

위에서 설명한 것과 같은 cross-attention map을 구할 때, clip에 mask를 적용한 multi-object crop을 도입했다고 한다.

이는 DINO에서 사용된 mask 기법과 비슷하지만, object 모양의 arbitrary shape을 가지고 전체 video frames에서 해당 object를 tracking하며 masking한다는 점이 다르다.

예를 들어, 객체 A가 프레임의 중앙에 위치하면, object A에 대한 mask는 중앙 부분이 1로 채워지고 나머지 부분이 0으로 채워지는 것이다.

마스크가 적용된 프레임은 각 객체를 개별적으로 분리하여, 모델이 개별 객체의 특징을 더 잘 학습할 수 있게 한다.

이 때 입력 프레임 Xt가 주어지면, standard resolution augmented global view Xat와 Xbt를 생성하며, 이는 동일한 프레임에 대해 두 가지 다른 resolution augmentation을 통해 얻은 reprentation이라 할 수 있다.

만약 u,v∈V={a,b},u!=v면 아래와 같이 설명할 수 있다.

- Teacher 모델은 하나의 global view Xut 에 대해 출력을 생성함

- Student 모델은 masked 버전 Xv,oit 에 대해 출력을 생성함 (여기서 Xv,oit는 global view Xvt에서 객체 oi가 마스크된 버전임

- 즉, 하나의 view는 teacher 모델에 입력되고, 다른 view는 student 모델에 입력됨

- 여기서 다른 view란, Teacher Model과 Student Model은 서로 다른 resolution을 가진 input을 입력받게 된다는 것을 의미함

- 예를 들어 Teacher Model에 Xa가 사용되었다면, Student Model에는 해당 frame의 다른 resolution에 mask를 적용한 Xb,oi를 사용하게 되는 것

- Teacher 모델의 [CLS] token output과 Student 모델의 masked [CLS] token output 사이의 차이를 측정하며, 이 차이를 최소화하는 방향으로 학습이 진행됨.

- Multi-object loss LOt는 여러 객체에 대해 각각의 [CLS] token output 간의 차이를 반영하여 계산됨

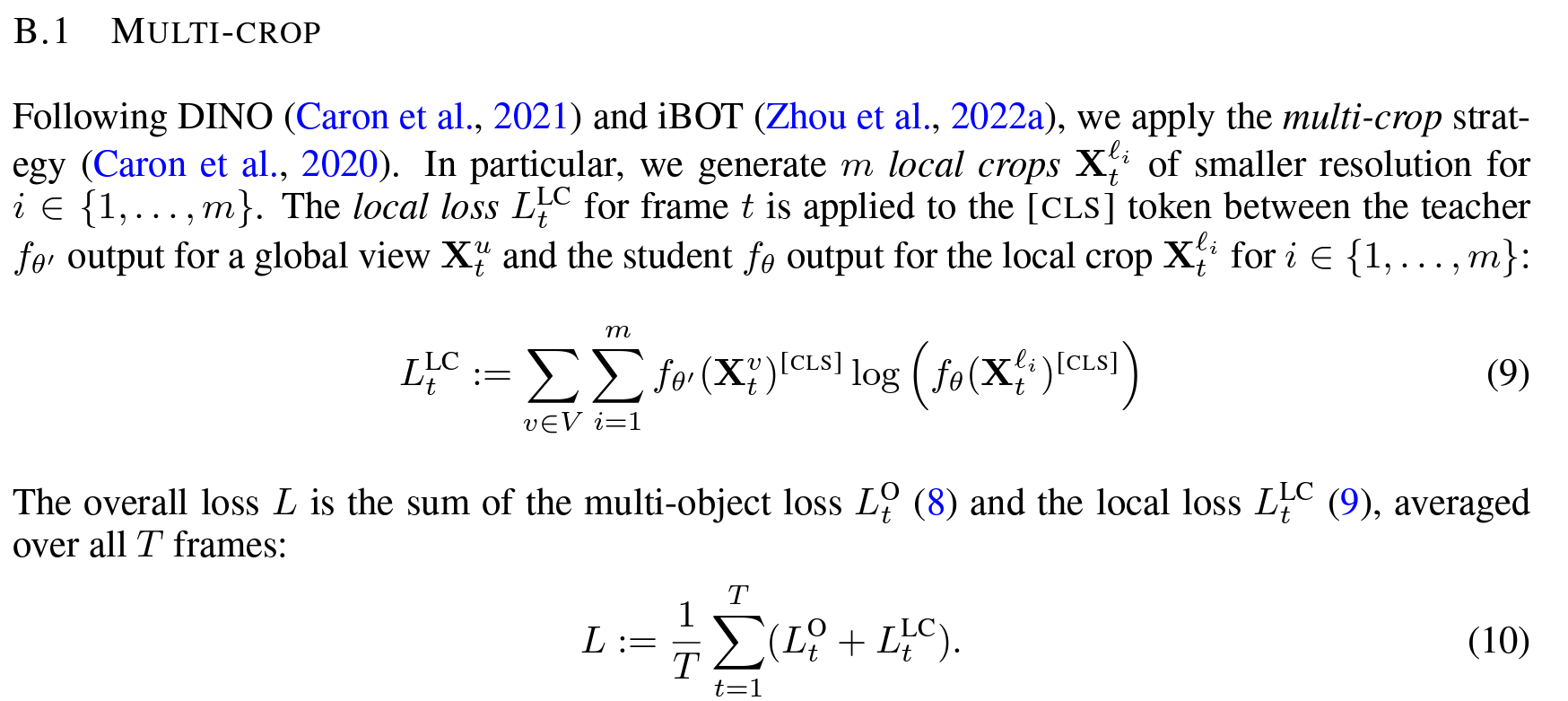

- 추가적으로 local loss와 multi-crop을 추가하여 전체 loss를 구성함

🌟 흐름 정리

- Teacher Network

- 첫 번째 frame t0에서 class prototype 구하여 각 object의 고유한 특성 찾아냄

- 이 때 각 object 간에 spatially overlapping되는 부분이 없도록 refine하는 과정을 거침

- 다른 frame t에서는 class prototype을 활용하여 attention map의 score가 높은 부분을 찾아내어 각 object를 tracking할 수 있음

- 첫 번째 frame t0에서 class prototype 구하여 각 object의 고유한 특성 찾아냄

- Student Network

- Teacher network에서 찾은 object를 통해서 mask 생성 후 target하는 object만 남긴 masked frame이 input으로 활용됨

- 이렇게 masked frame을 만들 때, Teacher network에서 사용했던 이미지와 다른 resolution의 이미지를 사용하여 다양한 global view에 대해서 익힐 수 있도록 유도함

- Training

- teacher network의 parameter는 student network의 parameter 값의 EMA를 통해 천천히 업데이트되며 distillation 시행

- multi-object loss는 아래 두 cls token의 차이를 최소화하는 방향으로 학습 진행함

- 전체 이미지를 입력으로 받은 Teacher Network의 cls token

- 우선 teacher network에서 사용된 resolution이 아닌 다른 resolution으로 augmentation을 취한 이미지에서 teacher network의 결과를 토대로 object를 찾아낸 뒤 그 외의 부분은 masking 처리한 이미지를 입력으로 받은 Student Network의 cls token

#AI최신논문 #AI최신논문리뷰 #딥러닝최신논문리뷰 #컴퓨터비전최신논문